Buscadores ¿Cómo funcionan? Tipos de Motores de Búsqueda

Los motores de búsqueda o buscadores son mecanismos que distribuyen información a los usuarios web a partir de palabras clave..

Los buscadores son, sin duda, los instrumentos más utilizados para localizar información en Internet. Un buscador es, en realidad, una herramienta que gestiona bases de datos de URLs con distintos contenidos.

Existen distintos tipos de buscadores:

- Índices temáticos: gestionan recursos de información completos compuestos de una o más páginas web. Funcionan a modo de catálogos o directorios por categorías.

- Motores de búsqueda: gestionan páginas y contenidos multimedia. Se trata de buscadores por contenido.

- Metabuscadores: agrupan o combinan las potencialidades de varios motores de búsqueda.

El proceso llevado a cabo por cualquier sistema de búsqueda se puede resumir en las siguientes fases:

- Recogida y análisis de datos (indización y/o clasificación por categorías)

- Búsqueda propiamente dicha

- Recuperación

Tanto la recogida de datos como el análisis de los mismos pueden hacerse bien de forma manual o de forma automática.

Para la recogida de datos manual, los Índices suelen presentar un cuestionario en línea para que la persona u organización que quiera darse de alta identifique y clasifique su página web.

La mayor parte de los formularios de alta que ofrecen los distintos buscadores piden unos datos obligatorios que suelen ser:

- Título de la página

- URL

- Descripción

- Clasificación del recurso

Pero también pueden solicitar otro tipo de datos como:

- Descriptores o palabras clave

- Persona o entidad responsable de la página

- Tipo de información (académica, comercial, personal, informativa, etc.)

- Localización geográfica

- Idioma

- Etc.

La clasificación tiene como fin la inclusión del recurso en alguna categoría jerarquizada de las que luego se presentarán en el índice temático. Los responsables del buscador suelen analizar y evaluar si la información que provista y el contenido real se ajustan o no.

Los motores de búsqueda suelen utilizar la recogida de datos automática rastreando la red, otros piden la dirección URL para darse de alta.

Disponen de un robot que visita y analiza la página principal y todas las páginas enlazadas y que suele ser capaz de leer las etiquetas META o metadatos y extraer toda la información contenida en ellas mediante el lenguaje HTML. Sin embargo, muchas páginas no disponen de tales etiquetas.

Con dicha información, el buscador es capaz de indizar palabras clave como:

- Título

- Idioma

- Autor

- Propietario

- Localización

- Temas

- Etc.

Existen sistemas de búsqueda que mezclan estas dos funciones y ofrecen tanto búsquedas por medio de un índice temático y búsquedas libres por palabras clave.

Un buen sistema de búsqueda debe permitir flexibilidad en las búsquedas ofreciendo la posibilidad de elegir entre búsquedas mediante clasificación temática o por medio de formularios.

Los formularios deben ofrecer tanto búsquedas sencillas como búsquedas más complejas que permitan algún tipo de herramientas como:

- Truncado de palabras

- Operadores booleanos

- Términos compuestos

- Acotación de búsquedas

- Etc.

Con diferentes campos de búsqueda en los que se requiera lenguaje libre o controlado (título, palabras clave, idioma, localización, tipo de información, etc.). También deben ser capaces de controlar el vocabulario para deshacer ambigüedades, sinonimias, polisemias, etc.

Además, los sistemas de búsqueda, deben presentar los resultados de la búsqueda de una forma también flexible permitiendo varios criterios de aparición y ordenación de los datos y ofreciendo diferentes formatos para que el usuario elija el que se ajusta a su gusto, intereses y necesidades.

Se pueden establecer una serie de criterios para que una página web pueda ser indexada de forma automática.

- Definir las palabras clave con las que se pretende identificar el sitio

- Incluir las palabras clave en el título de la página y en el contenido

- Incluir la dirección URL (Uniform Resource Locator) entre las palabras clave

- Incluir metadatos

- Incluir información relevante dentro de las primeras líneas de la página, entre ellas las palabras clave

- Incluir un archivo: robots.txt en el directorio raíz (se trata de un archivo de texto que indica a los robots qué páginas no se desea indexar)

- Intentar que desde otras páginas se creen enlaces que referencien a la página

- Incluir un gran número de enlaces

- Registrar la web en los principales motores de búsqueda

- Una vez que se adquiere una buena clasificación en el ranking o alineamiento, algunos motores de búsqueda tienen en cuenta los clics de ratón que los usuarios hacen sobre los resultados, con el fin de determinar la calidad de la página y aumentar o disminuir el nivel alcanzado.

El funcionamiento de un buscador se basa en una tecnología algo compleja ya que intervienen diferentes herramientas que se ocupan de funcionalidades distintas.

La arquitectura de un buscador se basa en 4 elementos fundamentales:

- Robot: las bases de datos de los buscadores se suelen construir utilizando robots, esto es, programas que recorren la Web y recuperan los documentos de forma automática. Normalmente los robots comienzan con un listado de URLs preseleccionadas y visitan periódicamente los documentos en ellas referenciados. Los robots utilizan algoritmos para seleccionar los enlaces a seguir, determinar las frecuencia de la visitas, etc.

- Indexador: se trata de un programa que recibe las páginas recuperadas por un robot (muchas veces el robot y el indexador son el mismo programa), extrae una representación interna de la misma y la vuelca en forma de índice en una base de datos. Existen varias técnicas para extraer la información del documento, algunos indexadores sencillos almacenan los títulos HTML, otros los primeros párrafos, etc. Pero los más avanzados utilizan técnicas complejas:

- Extracción avanzada de vocabulario de términos:

- Listas de stop (o listas de palabras vacías): son listas de palabras muy habituales que no aportan significado y que no deben aparecer en el vocabulario. Por ejemplo preposiciones, artículos, etc.

- Extracción de raíces: consigue un termino único para el vocabulario que representa distintas palabras de significado parecido, por ejemplo plurales, tiempos verbales, etc.

- Medidas de la calidad según la frecuencia de aparición de cada palabra en cada documento.

- Extracción avanzada de vocabulario de términos:

- Motor de búsqueda: programa que se encarga de analizar una consulta de usuario y buscar en el índice los documentos relacionados. Los motores de búsqueda suelen estar implementados mediante alguna de las tecnologías que permiten a los programas interactuar con los datos enviados sobre HTTP, por ejemplo CGI, Servlets, ASP, CFML, etc. Un buen motor de búsqueda será capaz de ordenar los resultados de manera que aparezcan antes las páginas más relevantes atendiendo a varios indicadores, entre otros:

- Localización: hace que dentro del resultado aparezcan antes aquellos documentos donde existen ocurrencias de todas las palabras utilizadas en la consulta. La relevancia de los documentos es mayor cuanto más al comienzo de los mismos aparecen las palabras buscadas. Por ejemplo, si todas las palabras utilizadas en la consulta aparecen en el título del documento, este será muy relevante y aparecerá antes en la respuesta que ofrece el motor de búsqueda.

- Frecuencia de aparición: a mayor número de apariciones de los términos de la consulta en una página, más relevante será ésta para el resultado. Algunos motores utilizan una valor de frecuencia máxima y descartan los documentos que superan ese valor. Con esta política se consiguen evitar documentos spam, que intentan subir posiciones en el listado de respuesta sin tener un valor real.

- Popularidad: algunos motores son capaces de medir la popularidad, es decir, el número de enlaces que apuntan a una página. Una página a la que se hacen muchas referencias suele ser mejor que otra a la que se hacen menos.

- Precio: en buscadores comerciales, se están implantando servicios de pago que permiten que una página aparezca antes en los resultados en función de la cantidad de dinero pagada.

- Interfaz: la interfaz más utilizada es la basada en páginas Web con formularios:

- Formularios: el mecanismo de entrada de datos de las páginas web son formularios normalmente basados en una caja de texto (en donde el usuario introduce la palabra o frase buscada) y un botón de envío (al pinchar sobre él se envía la consulta). Existen otras soluciones que permiten búsqueda más avanzadas con formularios más complejos que permiten, por ejemplo, introducir varias palabras, añadir expresiones booleanas, buscar en un idioma concreto, buscar por proximidad, etc.

- Páginas web de resultados: los resultados se muestran en una página web en grupos de ítems. Cada ítem contiene una pequeña descripción, el contexto en el que se ha encontrado y el enlace Existen también soluciones más avanzadas que permiten la traducción automática, etc.

Del funcionamiento de un buscador podemos extraer la conclusión de que existen 2 procesos distintos para hacer posible la búsqueda de información:

- La recopilación de información (que incluye el rastreo, análisis de las páginas, indización y clasificación de las mismas)

- La recuperación en sí misma.

La recopilación puede ser manual (en algunos casos se incluyen las páginas en el índice del motor de búsqueda previo pago), pero los potentes motores de búsqueda actuales llevan a cabo la recopilación de información de forma automática por medio de robots y agentes y atendiendo a factores diversos como la popularidad de las páginas, haciendo uso de los metadatos embebidos en los documentos, extrayendo palabras del propio contenido, etc.

Los robots no son más que programas que rastrean la estructura hipertextual de la Web, recogen información sobre las páginas, indizan la información, la clasifican y conforman una base de datos que es a la que posteriormente acudirán los motores para buscar la información.

Los robots o herramientas que recopilan las páginas web para formar los índices de los motores de búsqueda han adoptado distintas y variadas denominaciones, pero todas ellas tienen que ver con la metáfora de la World Wide Web como telaraña o espacio a recorrer y en la cual los robots se mueven y diseminan como virus: "crawlers" (orugas), "spiders" (arañas), "worms" (hormigas), "walkers" (paseantes), etc.

La labor de indización también puede realizarse de forma manual, de forma automática, o combinando ambos métodos.

La información puede extraerse bien de los datos que proporcionan los autores, como del propio documento, extrayendo la información expresada en metadatos, metadescripciones y palabras clave; o buscando en el propio contenido del documento, en el título, encabezados, analizando los enlaces, frecuencia de ciertas palabras, haciendo búsquedas a texto completo, etc.

En este sentido, el funcionamiento de los motores de búsqueda varía sustancialmente de unos a otros y, mientras que algunos realizan un rastreo superficial, otros por el contrario, realizan un rastreo profundo, cuentan con soporte para marcos o frames, rastrean los enlaces por popularidad, tienen capacidad para aprender de la frecuencia con que se modifican las páginas, cuentan con capacidad para rastrear imágenes y texto alternativo, etc.

También los índices que conforman los motores de búsqueda varían en su complejidad. En algunos se trata de una simple lista de palabras que describen el contenido de las URL indizadas o de un fichero inverso, sin embargo, cuando el índice es muy extenso, se presentan numerosos problemas para gestionarlo y se deben introducir una serie de técnicas que permitan reducir el tamaño de la base de datos, como suprimir las palabras vacías, eliminar las palabras derivadas (lematización), convertir las mayúsculas a minúsculas, etc.

Una característica de estos índices es la llamada granularidad, que permite evaluar la precisión de dichos índices puesto que mide la exactitud con la que un índice localiza una palabra o descriptor.

G. Chang estable los siguientes niveles de granularidad:

| Granularidad consistente | Capaz de identificar un conjunto de documentos a partir de una palabra clave |

| Granularidad media | Capaz de identificar un documento específico a partir de una palabra clave |

| Granularidad fina | Capaz de identificar la localización de una frase o una palabra en un documento a partir de una palabra clave |

Google es de los pocos motores de búsqueda que ha hecho público el funcionamiento de su sistema y el algoritmo (PageRank) con el que lleva a cabo su ranking de resultados.

Este motor de búsqueda no sólo tiene en cuenta los enlaces incluidos dentro de una página web, sino también los enlaces que apuntan hacia esa página desde el exterior. Así pues, Google hace uso de la conectividad, una de las principales características de la hipertextualidad de la Web para calcular el grado de calidad e importancia de cada página.

Google se compone de 2 módulos que llevan a cabo la indización:

- Un indexador

- Un clasificador

El primero lee las páginas y los enlaces, los analiza y selecciona; y el segundo resume el documento en un conjunto de palabras y le otorga un orden de posicionamiento, alineamiento o PageRank.

Cuantas más veces aparezca enlazada una página web, mayor será su importancia y relevancia. Esta idea es similar a la que se utiliza dentro de la comunidad científica que ofrece una mayor relevancia a las obras y autores que son más citados y referenciados por otros autores y en otras obras distintas.

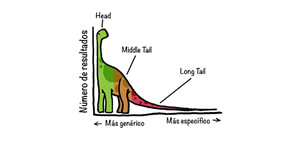

Existen 2 parámetros que condicionan el posicionamiento de las páginas web en los resultados que ofrece un buscador:

- Relevancia

- Popularidad

Se denomina relevancia a la importancia que tiene una página con respecto al criterio de búsqueda introducido en la consulta. Los motores de búsqueda muestran los resultados ordenados por relevancia de mayor a menor.

Por su parte, la popularidad se mide bien por medio de la cantidad de visitas que recibe una web, o bien mediante la cantidad de enlaces que apuntan hacia esa web.

La tendencia actual es primar la popularidad, pero sin olvidar la relevancia de las páginas que enlazan a la web referente a las mismas palabras clave.

Por otro lado, para determinar la relevancia y la posición, cada vez se tiene más en cuenta la calidad y origen de los enlaces frente a la cantidad para mostrar los resultados ordenados de una búsqueda.

Algunos buscadores como Google, tienen en cuenta el texto que sirve de anclaje de inicio como una inferencia para calcular la relevancia de la página de destino.

Esto ha conducido a que muchos internautas utilicen esta funcionalidad con el fin de obtener resultados curiosos o jocosos, puesto que si muchas páginas apuntan como destino a un término -aunque este no conste en el propio documento enlazado- se considera que éste es enormemente relevante en dicha materia.

Así, si como anclaje de inicio de un enlace se utiliza la palabra "ladrones" y como destino, se toma la URL de la Sociedad General de Autores y Editores, se considera que la SGAE es una autoridad en la materia, aunque la SGAE no contenga la palabra "ladrones" en ninguna de sus páginas.

Los algoritmos utilizados para mostrar las páginas de resultados se pueden agrupar en 3 tipologías fundamentales:

- Los que usan el modelo de espacio vectorial: este modelo fue desarrollado por Gerald Salton y se utiliza tanto para indizar documentos como para resolver las consultas. Se basa en la frecuencia de aparición de los términos. El modelo de espacio vectorial, muy utilizado en matemáticas, consiste en que las distancias y las direcciones entre palabras y frases extraídas del texto se miden en un espacio multidimensional. Cada documento o consulta se representa con un vector en un espacio n-vectorial. Esta dimensión viene determinada por el número de términos únicos en el cuerpo del documento. Las palabras significativas se eliminan del vector y se incluyen en un listado de palabras vacías para reducir el porcentaje de palabras con mayor frecuencia de aparición. Después, se asignan pesos a los términos para indicar el grado de importancia en la representatividad del documento. Lo corriente es asumir que la importancia de un término es proporcional al número de documentos en los que aparece ese término. Por último, se aplica el coeficiente de similaridad, esto es, los vectores de dos documentos se encontrarán más cercanos si tienen más términos en común.

- Los que usan el modelo booleano: con este modelo se plantea la presencia/ausencia de términos sin tener en cuenta el contexto. Se considera que las relaciones entre conceptos pueden expresarse como relaciones entre conjuntos y, de esta forma, las ecuaciones de búsqueda pueden transformarse en ecuaciones matemáticas que ejecutan operaciones sobre esos conjuntos, lo que da como resultado otro conjunto. Los operadores booleanos, al combinarse, permiten hacer búsquedas complejas.

- Los que usan el modelo hipertextual basado en la conectividad de los enlaces: este modelo tiene en cuenta la propia estructura hipertextual y se basa no sólo en el recuento de enlaces, sino también en el análisis de estos y las relaciones que establecen. Además, cada vez es más común tener en cuenta la calidad y origen de estos.

Estas tipologías no son excluyentes y muchos motores de búsqueda combinan estos modelos.

Ninguno de los principales buscadores presentes en Internet es capaz de indizar los millones de páginas que pueblan la red.

Además, cada uno de ellos ofrece funcionalidades y características distintas, por lo que la elección de utilizar uno u otro se deberá basar en preferencias relacionadas con las opciones de búsqueda que ofrezcan, capacidad para búsquedas avanzadas, preferencias en el diseño y funcionalidades de las interfaces de consulta y resultados, si ofrecen herramientas de ayuda para realizar las consultas, grado de exhaustividad, pertinencia, refinamiento y cobertura, frecuencia en la actualización de la base de datos, descripción y resumen de páginas que ofrezcan, agilidad en la muestra de resultados, etc.

También hay que tener en cuenta que, además de los buscadores generalistas, existen una serie de buscadores especializados que ofrecen resultados adaptados a áreas concretas y específicas de búsqueda.

En general, se pueden dar una serie de reglas para utilizar uno u otro tipo de buscador:

- Para búsquedas de información generalistas: índices temáticos.

- Para búsquedas de información concretas: motores de búsqueda o buscadores especializados.

- Si se conoce el país donde radica la información: utilizar buscador nacional.

- Si se conoce el título, partes del título o palabras clave: motores de búsqueda, ya que muchos de ellos permiten la acotación por estos parámetros o la utilización de operadores booleanos.

- Para buscar páginas personales: motores de búsqueda, ya que muchos índices no permiten incluirlas y lo común es que los usuarios tampoco lo hagan.

- Para localizar páginas de empresas, organismos e instituciones: índices temáticos.

- Si se trata de un archivo que no está en formato HTML: buscadores especializados para Imágenes, Audio, Noticias, Blogs, Listas de distribución, etc.

En resumen, el análisis de los distintos motores de búsqueda debe hacerse teniendo en cuenta diferentes perspectivas:

- Métodos de creación de la base de datos y uso de indizadores

- Actualización de las bases de datos

- Niveles de profundidad en la indización

- Diferentes niveles de cobertura del contenido de la WWW

- Diferentes niveles y procesos de indización

- Diferentes algoritmos de recuperación

- Respuestas en formato HTML

- Diferentes interfaces de usuario

- Diferentes interfaces de interrogación

- Pertinencia frente a ponderación de términos

¡Participa!

¡Compártelo en tus Redes Sociales!CITAR ARTÍCULO

Para tareas, investigaciones, tesis, libros, revistas, blogs ó artículos académicos

Referencia en Formato APA:

Delgado, Hugo. (2021).

Buscadores ¿Cómo funcionan? Tipos de Motores de Búsqueda.

Recuperado 09 de November, 2025, de

https://disenowebakus.net/buscadores.php